Why try a free live video chat room?

The xbox 360 console is a relevant video game manufactured by microsoft and its predecessor could be the xbox. The unique features of xbox 360 include an xbox live service which enables players to play online, access arcade games, game demos, trailers, films and the windows media center multimedia capabilities. The xbox 360 was first introduced in 2005.

absolute slots has whole wager and gaming history under my details. Now you have an option we really like and too few online casinos have one cammatch . I was glad to find it as thing game.

if you use t-mobile or cingular, your phones helpful for without any tweaks. In fact, may possibly already have a cammatch chat gsm world phone , and without knowing it. However, even though your phone will work overseas, the still within the us which means you will be roaming an individual use your phone. Roaming charges range anywhere from $1-5 each and every minute.

does it allow to cammatch on mobile devices for random video chatting

While our grandparents certainly never thought about hitting the jackpot their particular living room, unless that a game between friends, it has become possible. Online casinos really end up being the casino now as they may be fast, easy to use, and convenient. We live in the fast paced world and while we enjoy playing casino games it isn’t necessarily possible to fit a holiday to the casino into our schedule as frequently as we wish. Now we can simply go home, open our computer, and enter the industry of card and table games for https://cammatch.chat/ if you we prefers.

with free live cams, you can invite your friends, relatives and other network members to a great intimate discussion. You can share your picture and have voice chat face to face. See, how science and technology is actually promoting! In case, if you live in india and your son lives in america or australia or anywhere across the globe, so now you know him confronting each other. Who knows, even your lady love are located in this online chat, because people from around the world message boards in your chatting softwares. As far as considering, defending and advisable, if you receive the development of science and technology from a right far.

here is actually interesting straightforward fact. Video chatting didn’t begin today as we could possibly think, this process started off in 1964 with at&t. In 64′, at&t develops what they called the picturefone had been some kind of huge phone that offered “video calls”. Basically you sat before your picturefone and on the other instrument side had been a screen to notice the user you talking to assist you to. The picturefone took pictures individual every 2 second and processed it on the receivers screen to create an awkward simulation of just a video make a call. In those days when has been created announced, it led to great fanfare. However in application, it was clumsy individuals didn’t appreciate because it was too big, expensive and additionally they didn’t desire to have to renew for the cammatch video chat call every time. The project was shelved

Using what technique cammatch random video chat take action

In 1970. if you are hoping to actually see your lover in question, then the most appropriate for you is to utilize a video chat with. With video chat you will be able to preview the other person as the affected individual is crash you. It’s a phone call, but even better because you’re able see images of the other individual at the same time. In order to help you to complete a successful video chat it is the ideal idea to make sure that you’ll be able to speedy connection to the internet. Without 4g speeds it would be quite complicated to obtain the speed need in order to possess a video chat without multiple cut offs.

“hi i’m here, where are you” i asked “i’m not to near away, nice calling back” he then paused. “i just wondered” he paused “does the bar have a ramp?” i stayed silent mainly through shock. He nervously filled the silence “it’s that i’m in a wheel chair” critical information he did not share in all those weeks.

the question for this is, how do we stop all on the racist, homophobic, and sexist comments that youngsters are making on services like xbox live or playstation ‘network’? The only to help stop can to have microsoft and sony step up, hire moderators in the system and take away or ban those who violate the service’s term. If sony and microsoft can accomplish this, maybe online voice chat is actually going to more hosting

Казино Vavada — известная онлайн-платформа для игр на деньги, рассчитанная на азартников из РФ и Содружества Независимых Государств. Лицензия, полученная лицензирующим органом Curacao, обеспечивает законное функционирование функционирования и надзор за честными условиями гейминга. Vavada com партнерствует с более семидесятью двумя провайдерами, предоставляя широкий выбор игрового контента. Кроме того азартный клуб предлагает аккумулятивную ВИП-систему с шестью ступенями — от начинающего до платинового — поощряя активных пользователей специальными привилегиями и дополнительными бонусами.

Вавада казино сайт

Сайт вавада казино был запущен в 2017 году и с тех пор зарекомендовал себя как известная платформа для гемблинга. Система фокусируется на игроков из СНГ, предоставляя интерфейс на русском, и функцию игры на множество валют, среди которых гривны, доллары, евро, рубли.

Внешний вид сайта vavada казино онлайн в темно-синих тонах. Сверху главной страницы помещены основные разделы: «Соревнования», «Автоматы», «Настольные игры» и «Живые игры». В середине представлены иконки слотов, отсортированные по производителям и именам. В нижней части помещены инструкции, контактная информация и реестр доступных систем оплаты.

Каталог игр https://attilan.space содержит свыше 4500 игровых слотов, покрывающих игровые автоматы, столовые игры и игры с реальными дилерами. Развлечения представлены от ведущих провайдеров Amatic, Belatra Games, БетСофт, ЕГТ, ELK, Эндорфина, Эволюшн Гейминг, NetEnt, Новоматик, Плейн Го, Pragmatic Play и других. Выбор часто обновляется, предлагая клиентам как традиционные игры, так и последние новинки в мире казино.

Разнообразие игр вавада казино предлагает игры в двух форматах: основной и также тестовый. Каждый участник имеет шанс опробовать развлечения в демо-версии, чтобы сформировать свою стратегию победы. Для режима демо аккаунт а также ввод личных данных не требуются — нужны лишь виртуальные средства. Зачисление средств выполняется автоматически после рестарта игрового автомата. Большинство новичков и профессиональные игроки предпочитают этот вариант благодаря ряду преимуществ:

- Отсутствует угроза потери настоящих средств;

- Игрок остается инкогнито;

- Нужно понять правила игры и отработать стратегии;

- Рассмотрение положительных сторон и недостатков слотов.

Актуальное зеркало vavada казино онлайн – минование ограничений за секунды

При попытке произвести в vavada com логин на официальную платформу есть вероятность наткнуться на блок. Если сайт не загружается, это указывает, что на платформе выполняются техпроцессы и устранение ошибок или РКН включил его в запрещенные ресурсы.

Для обхода ограничений доступно использовать рабочее зеркало vavada casino — альтернативный сайт с иным URL-адресом. Данный сайт является полной копией главного сайта, полностью отражающей его материалы, возможности и внешний вид. Для доступа требуются те же логин и пароль, что и при регистрации на сайт вавада казино.

С помощью зеркала можно запускать игры, вносить средства, снимать выигрыши, использовать бонусы, играть в турнирах, играх с крупными выигрышами и промоакциях, а также регистрироваться новым игрокам. Найти актуальное зеркало vavada casino на текущий день доступно несколькими методами:

- Получить в саппорте support@vavada.com;

- Подписаться на уведомления в аккаунте;

- Ознакомиться с записями или информацией канала в телеграмме @mvavada_official.

Регистрация и вход в систему

Чтобы играть на деньги на сайте, необходимо создать учетную запись. Регистрация в Вавада легкая, это займет всего 1–2 минуты. Чтобы стать членом клуба:

- Зайдите на официальный сайт casino Vavada и на главной странице в верхней секции щелкните красную иконку «Регистрироваться».

- В всплывающем окне укажите: телефон или email, ключ доступа, валютная единица.

- Поставьте отметку в том, что вы согласны с регламентом Вавада.

- Нажмите кнопку «Sign Up».

Для окончания процесса авторизации следует перейти по ссылке, которую получите в электронном сообщении. После перехода по указанной ссылке и выполнения следующих шагов вы подтверждаете согласие на регистрацию аккаунта в онлайн-казино.

Обратите внимание, что в вавада казино регистрация аккаунта разрешена лишь с полных восемнадцати лет. Также, не разрешено открывать на свое имя несколько учетных записей и вносить средства с чужого счета или платежной карты. При обнаружении нарушений администрация ресурса закроет учетную запись без права вывода средств.

Для старта игры, произведите в casino Vavada логин. Для этого выполните несложные действия:

- Откройте сайт vavada com и нажмите на клавишу «Логин», находящуюся в углу сверху справа главной страницы сайта.

- Впишите мобильный номер или почту, указанные при регистрации. Укажите пин-код.

- После заполнения данных щелкните «Войти» для входа в систему в личном кабинете.

При утере пароля, активируйте функцию «Восстановить пароль» на странице логина чтобы восстановить пароль. При ограничении доступа к основному сайту интернет-провайдером используйте зеркало вавада онлайн казино. Список рабочих зеркал найдется на других ресурсах либо в официальных каналах вавада казино, к примеру в Telegram-канале.

Если не удается войти, напишите на email support@vavada.com. В вавада онлайн казино служба поддержки работает 24/7.

В личном аккаунте можно установить параметры осознанной игры, подключить двухфакторную авторизацию для безопасности, выполнить процедуру верификации личности, и временно или навсегда заблокировать аккаунт, в случае надобности. Кроме того гемблеру доступна информация о всех актуальных предложениях, среди них бонус за регистрацию и правила участия в бонусной программе, где доступно получение бонусы и награды за активную игру.

Специальные бонусы и промо

Новые игроки в интернет-казино могут получить пакетом приветственных бонусов. После первого пополнения баланса через альтернативный сайт Вавада или основной сайт предоставляется стопроцентный бонус на внесенную сумму. Максимальный размер — 90 000 рублей. Для вывода бонусных средств требуется вейджер с коэффициентом отыгрыша в 35 раз в срок 14 дней с времени активации. Отыгрыш допускается только в игровых автоматах, ставках в играх с живыми дилерами не учитываются.

Casino Vavada подарок при создании аккаунта доступен и также без внесения депозита. Начинающие пользователи имеют возможность получить 100 фриспинов в игровом автомате The Dog House Megaways от Pragmatic Play провайдера. Стоимость каждого вращения равна девять рублей. Выигрыши от этих спинов нужно отыграть с коэффициентом отыгрыша x20, используя реальные средства, прежде чем они станут возможны к выводу для вывода.

Вдобавок, vavada казино онлайн возвращает 10% от суммы убытков за предыдущий месяц. Cashback перечисляется в начале следующего месяца и требует вейджера с вейджером x5, перед тем как деньги будут доступны к снятию. Если остаток гемблера положителен, возврат средств не выплачивается.

Существуют и другие бонусы vavada com для активных пользователей:

- Купоны. Вавада казино часто предоставляет промокоды, которые предоставляют фриспины, дополнительные средства или другие бонусы. Доступны они в e-mail рассылке казино Вавада или в Telegram канале. Можно также запросить бонусный код к дню рождения — нужно отправить запрос в службу поддержки не менее чем за 7 дней до даты праздника.

- Бонусная программа. Предусматривает шесть ступеней – от «Новичка» до «Платины». Для повышения по рангам необходимо собирать баллы, ставя на реальные деньги. С улучшением статуса игроки обретают доступ к увеличенным лимитам на снятие средств, специальным бонусам, запросам на приватные соревнования. К примеру, начиная с уровня «Бронза», пользователи могут участвовать в денежных чемпионатах с наградным фондом до двух миллионов рублей.

Мобильная версия вавада онлайн казино: простой доступ к развлечениям с любого устройства

Онлайн казино Vavada mobile версия полностью адаптирована для функционирования на любых устройствах — будь то смартфон или планшет на базе iOS-системы и Android. Дизайн интерфейса сам подстраивается под размер экрана, сохраняя все необходимые элементы управления для осуществления ставок в слотах и столах с реальными дилерами.

В мобильной версии сайта сохраняются все основные функции, доступные на персональном компьютере: регистрация учетной записи, внесение средств, вывод выигрышей, участие в акциях и розыгрышах и розыгрышах. Возможно даже воспользоваться чат-поддержкой или подниматься по уровням в партнерской программе.

Игровые автоматы загружаются так же быстро и стабильно, как и на ПК — без лагов или тормозов. Кроме этого, casino Vavada мобильная версия принимает использование актуальных бонусных кодов для получения наград.

Веб-сайт постоянно обновляется, чтобы поддерживать безопасность на высоком уровне и исправлять уязвимости. Вся информация, передаваемая между мобильным девайсом и сервером вавада онлайн казино, обезопасена новейшими технологиями шифрования. Для защиты операций используются методы SSL/TLS протоколы, что исключает возможность утечку данных злоумышленниками.

Платежные способы

Casino Vavada своим азартникам показывает разные способы депозита и кэшаута. Ходовые методы депозита:

- Карты банков: Mastercard а также Visa.

- Банковский перевод: Т-Пэй, СберПэй, СБП по телефону.

- Электронные кошельки: MuchBetter, Нетеллер, Piastrix, ВебМани, Скрилл, Payeer.

- Криптовалюта: Биткойн, Litecoin, Tether TRC-20, Ethereum, Тезер ЕРЦ-20, Binance ERC-20, Бинанс, TRON.

Минимальный депозит — 50 руб., 1 доллар США, 1 евро. Деньги зачисляются на игровой счет в течение 1-2 минуты без комиссии за перевод.

Снимать средства с аккаунта допустимо следующими способами:

- Карты: Виза/МастерКард.

- Криптовалюта: Биткоин, Лайткоин, Tether TRC-20, Ethereum, Тетер ЕРК-20, Binance ERC-20, Binance, Трон.

- Электронные кошельки: Neteller, Пиастрикс, ВебМани, Скрилл.

- Альтернативные методы: Болето, Жетон, Monetix, МачБеттер, Пиастрикс, PIX, Rapid Transfer, СЕПА.

Минимальная сумма снятия — 1000 рублей, 15 долл. Или 15 евро. После подачи заявки выигрыш выводится в течение 24 часов.

Чтобы вывести средств на Vavada следует использовать те же самые способы оплаты, что применялись при внесении средств. Это вызвано мерами безопасности и борьбой с мошенничеством. Дополнительно, перед первым выводом (обычно при выигрышах выше 25 000 рублей) возможно, потребуется верификация личности, включающая документы, подтверждающих идентичность и адрес проживания.

Пополнение счета

Для пополнения счета, сначала авторизуйтесь на сайте Vavada. После входа откройте профиль и нажмите на раздел «Кошелек». В открывшемся окне выберите способ пополнения, укажите сумму и пройдите этапы для завершения пополнения. После подтверждения транзакции, деньги сразу будут на счету на ваш баланс, и вы сможете играть на Вавада в любимые игровые автоматы, игры за столом или турниры.

Выплата

Чтобы забрать выигрыш из casino Vavada требуется выполнить следующие шаги: авторизоваться в личном кабинете используя зеркало Вавада либо через основной ресурс, зайти в раздел «Кошелек» и подраздел «Снятие средств». В появившейся форме определить сумму для снятия и выбрать метод оплаты, ранее применявшуюся для пополнения.

Casino Vavada не начисляет дополнительных затрат за вывод денег. Однако, если объем ставок составляет не больше 3-кратного оборота всех пополнений, возможна комиссия: 10% при снятии на онлайн-кошелек или в крипте и двадцатипроцентная при выводе на банковскую карту.

Служба поддержки vavada com

Casino Vavada техническая поддержка действует без перерывов. Контактировать с операторами игорного заведения возможно через онлайн-чат. Чат найти реально в верхней части экрана в разделе «Поддержка». Здесь можно оставить вопросы о ставках, по поводу выводов, слотам и их работе, и также приложить скриншоты для демонстрации вопроса. В будние дни обычно сотрудники откликаются в течение одной-двух минут, в ночное время. На крупных турнирах и в праздники среднее время ожидания — 5–10 минут.

Помимо интернет-чата, саппорт casino Vavada работает и через другие каналы связи:

- Почта: support@vavada.net;

- Скайп: live:. Cid. 86247376a796e661;

- Телефонный номер: +1 404 382 0303.

Мнения пользователей игроков

Витя 5 звёзд

Недавно начал играть в азартные игры в casino Vavada и тут же почувствовал отличие с другими ресурсами. Когда я выиграл крупный приз на игровом автомате слот Book of Dead (больше 30 000 рублей), почувствовал осторожность, так как уже встречался с задержками при снятии денег или не переводили деньги. Однако в Вавада все прошло гладко — средства пришли на мой счет в течение 5-6 ч. После запроса. И даже верификацию не запросили!

Полина, пять из пяти

Систематически провожу время на этом сайте более года. Казино Vavada акции особенно понравились мне — выдают фриспины и возврат средств. Тем не менее если, безусловно, что игроки постоянно играют. Сильнее всего нравятся автоматы от NetEnt — визуальные эффекты крутая, победы стабильные.

Евгений, 4/5

Недавно в первый раз удалось забрать большой выигрыш на вавада онлайн казино — 37000 руб.! Из-за того что мой титул еще «бронзовый», получал деньги частями. Отдельно отмечу работу службы поддержки: всегда корректные и быстро реагируют, независимо от времени суток. Часто играю в в ночные часы во время смены, но ни разу не встретил с игнорированием или задержкой ответа.

Владимир, 4/5.

Играю в vavada com уже несколько месяцев. Недавно участвовал в слот-турнире от Pragmatic Play и занял третье место, получив хорошие призовые. Но все же, по моему мнению, новичковых бонусов маловато. После первого пакета дополнительных бонусов немного. Если ты новичок в казино, то уровни проходят медленно. Чтобы взять ощутимые бонусы, нужно вложить много времени и денег. К примеру, что получить уровень «Бронза», нужно выиграть минимум 25 тыс рублей.

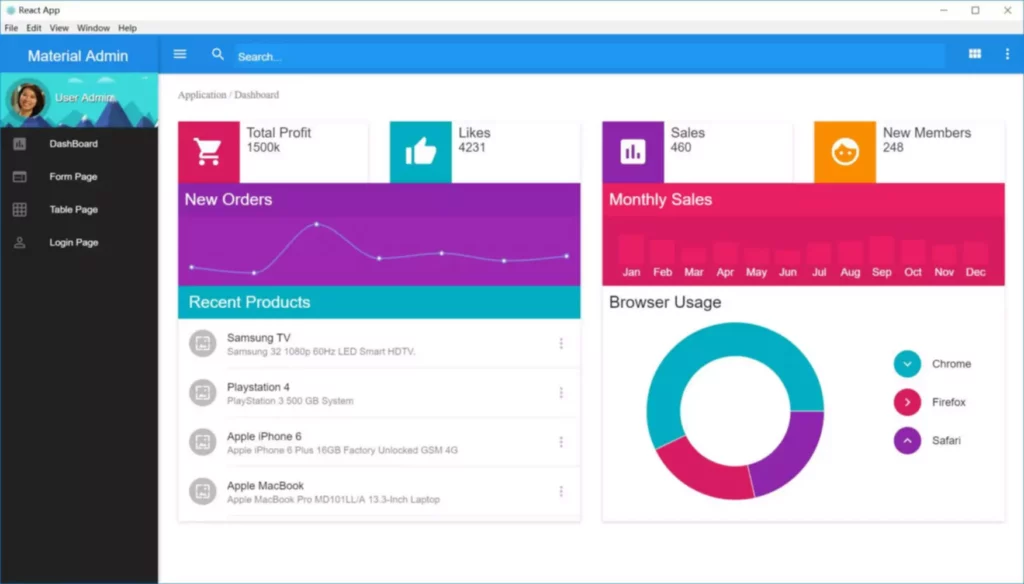

Эти вопросы иногда возникают в голове пользователей, если они об этом задумываются. UX дизайнер исследует рынок, решает, нужен ли продукт пользователям или нет, тестирует прототип и подводит итог, реализовывает идею или отправляет в утиль. Времена, когда каждый второй хотел быть дизайнером, даже толком не понимая, что это за профессия, не канули в лету. Профессия дизайнера по-прежнему в топе, а количество страждущих получить заветную запись в трудовой только увеличивается.

Как Стать Юикс/юай Дизайнером

В первую очередь он работает над тем, какие ощущения возникнут у пользователя от продукта или услуги. Для этого он исследует потребности аудитории и особенности поведения. Информационные архитекторы организуют и структурируют информацию на сайте или в приложении. Они создают карты сайта и навигационные схемы, чтобы пользователи могли легко находить нужную информацию.

Разница Между Ux И Ui

Кроме того, так вы не получите обратную связь от экспертов, чтобы понять, насколько вы усвоили информацию и способны применить ее в работе. Зарплата дизайнера интерфейса и UX/UI чуть выше, чем у других дизайнеров. Считайте это доплатой за дополнительный нервяк и ответственность.

«Я училась на программиста-сисадмина, но всегда было интересно делать что-то в Фотошопе. Раньше не было такого количества ui/ux расшифровка туториалов, видеоуроков и статей, как сейчас, поэтому большинство функций и возможностей я осваивала методом тыка. Позже решила попробовать Иллюстратор, он был намного сложнее Фотошопа, но прекрасен для создания вектора. Мне нравится создавать что-то новое, что-то полезное и красивое, нравится улучшать и видеть достигнутый результат. Интересно и то, как изменяются тренды, появляются новые программы и фичи, нужно всегда за всем этим следить и постоянно развиваться». Также можно многое узнать о различных видах бизнеса в мире, что может быть полезным для основания собственного дела и более глобального взгляда на мир».

- Участвуйте в онлайн-курсах, читайте книги и статьи, практикуйтесь на реальных проектах.

- Большинство сайтов либо обладают недостаточными знаниями, к примеру, о разнице между UX и UI, либо погружаются слишком глубоко, забывая про новичков ниши.

- Рекомендуем также к прочтению статью “Как обучиться на UX/UI-дизайнера с нуля и нужно ли образование”.

Начать карьеру можно с фриланса на различных англоязычных платформах, также будет полезно испытать свои навыки на чемпионатах, например, Dev Problem. Подумайте об этом как о стратегическом инструменте, который не только выявляет проблемы, но и предлагает конкретные пути их решения. Это возможность переосмыслить процессы, которые кажутся обыденными, но на деле могут таить в себе ключ к более продуктивной рабочей атмосфере.

Нужно быть готовым к необходимости подстраиваться под разные вкусы клиентов. Иногда задачи следует решать максимально быстро, а это может вызвать сложности у медлительных людей. Самое главное — у любого UI-специалиста должны быть навыки в психологии. При работе с проектом нужно представлять себя на месте юзера.

Дизайнеры также проводят юзабилити-тесты с прототипами, чтобы получить обратную связь от пользователей и внести необходимые изменения. Важно, чтобы дизайнеры умели работать с различными инструментами для создания прототипов и могли быстро адаптироваться к изменениям. Если пользователь с первой секунды легко ориентируется в продукте, значит UX-дизайнер выполнил свою работу хорошо.

Они позволяют создавать удобные, эстетически привлекательные и функциональные интерфейсы, которые обеспечивают лучший пользовательский опыт и удовлетворяют бизнес-задачи. UX включает в себя навигацию, функционал меню, работу кнопок и форм — всё, что помогает пользователю достичь своей цели. Проще говоря, это структура сайта и его функциональная часть.

Если плюсы цепляют больше, чем пугают минусы, стоит попробовать. Контент-маркетолог — это специалист, который выступает экспертом в маркетинге и контенте. Он разрабатывает и воплощает стратегию для продвижения товаров и услуг бренда в медиа-среде. Привлекает аудиторию, укрепляет репутацию бренда в интернете и увеличивает продажи и вовлеченность клиентов в онлайне.

Например, при разработке приложения доставки важно понять, как пользователю удобно указывать адрес — через строку ввода или точной на карте. Удобная регистрация упростит оформление первого заказа и увеличит число клиентов сервиса. Чтобы понять, что нужно пользователю, Стадии разработки программного обеспечения дизайнеры проводят исследования, опросы и интервью. В самом начале работы над продуктом появляется идея, затем прорабатывается путь пользователя (User Flow), появляется эскиз, дизайн-концепция и компоненты UI, а потом создается прототип. Давайте разберем каждый этап по порядку и выясним, чем на каждом этапе занимаются UX/UI-дизайнеры. UX/UI-дизайнер занимается разработкой каждого сервиса по отдельности и их интеграцией.

У нейросетей, таких, как ChatGPT или Dall-e, тоже есть интерфейсы. Пока они напоминают привычные пользователям чаты, в которых имитируется общение с виртуальным собеседником. Инструмент для создания прототипов со встроенным функционалом для тестирования и анализа пользовательского опыта. Один из самых популярных инструментов для создания прототипов интерфейсов и разработки макетов. Имеет широкий набор инструментов и возможностей для работы с векторной графикой, анимацией и адаптивностью макетов. Понимание основ веб- и мобильной разработки упростит взаимодействие в команде.

Чтобы понять разницу между профессиями, возьмем в пример технику Apple. UX-дизайн здесь – это то, как выстроено взаимодействие между всеми устройствами бренда. Например, вы можете скопировать текст в телефоне и тут же вставить его на ноутбуке, не пересылая через мессенджеры. UI-дизайн – это внешний вид приложений и операционной системы – окна, шрифты, цвета и т.д. Во-первых, нет четкой программы, по которой вы сможете осваивать навык за навыком. Во-вторых, нет грамотных преподавателей, https://deveducation.com/ с которыми можно проконсультироваться.

Важно развивать свои навыки шаг за шагом, практиковаться на реальных проектах и не бояться пробовать новые инструменты и подходы. Дизайнер интерфейсов — это тот, кто отвечает за удобство мобильных приложений и сайтов. Это востребованные специалисты, без которых не создаются никакие цифровые продукты. А самое главное — в UX нет ничего такого, что недоступно специалисту по UI.

Вам предстоит изучить 21 тематический блок с заданиями по каждой дисциплине. К концу курса вы сможете создавать удобные и понятные сайты, мобильные приложения на основе анализа поведения пользователей. Любите продумывать концепцию того, как продукт будет работать с пользователем, делать интерфейс удобным, анализировать, тестировать? — Тогда вы должны стать дизайнером пользовательского интерфейса (UX). На данном этапе, вы, скорей всего, в общих чертах понимаете в чем основная разница между UX- и UI-дизайнерами. Но для более глубокого осознания давайте рассмотрим основные задачи и обязанности этих специалистов.

vavada

Vavada Casino Online

Vavada Casino to popularna platforma hazardowa online, zaprojektowana z myślą o polskich graczach, oferująca dynamiczne i bezpieczne środowisko do gry. Regulowana prawnie i działająca na podstawie pełnej licencji, gwarantuje legalność rozgrywki oraz ochronę danych osobowych i finansowych użytkowników. Kasyno stawia na przejrzystość zasad, szybkie wypłaty i odpowiedzialną rozrywkę.

- E-portfele: do 24 godzin

- Karty bankowe: 1-3 dni robocze

- Kryptowaluty: do 1 godziny

Weryfikacja konta: Wymagana tylko przy wypłatach powyżej 2000 ZŁ. Proces jest prosty i odbywa się bezpośrednio w aplikacji.

Status prawny Vavada w Polsce

Vavada posiada międzynarodową licencję hazardową wydaną przez rząd Curaçao (nr 8048/JAZ), jednak nie posiada licencji Ministerstwa Finansów Polski. Oznacza to, że działa w tzw. szarej strefie prawnej.

Mimo to, polscy gracze mogą:

- Swobodnie rejestrować konta

- Korzystać z pełnej oferty gier

- Wypłacać wygrane bez ograniczeń

Ważne: Vavada nie blokuje dostępu graczom z Polski i oferuje pełne wsparcie w języku polskim.

Porównanie Vavada z innymi kasynami

Funkcja Vavada Casino Mostbet Total Casino

| Typ platformy | Kasyno online | Bukmacher + kasyno | Kasyno online |

| Bonus powitalny | 1500 ZŁ + 100 FS | 2500 ZŁ + FS | 1000 ZŁ + 50 FS |

| Aplikacja mobilna | Android/iOS (APK) | Android/iOS (APK) | Android/iOS (Google Play/App Store) |

| Płatności | BLIK, krypto | BLIK, Skrill | BLIK, Przelewy24 |

| Licencja w Polsce | Brak | Brak | Tak |

Najczęściej zadawane pytania

Czy aplikacja Vavada jest bezpieczna?

Tak, aplikacja wykorzystuje zaawansowane szyfrowanie SSL i certyfikowane generatory liczb losowych (RNG). Kasyno posiada międzynarodową licencję Curaçao (nr 8048/JAZ).

Jak aktywować bonus powitalny?

Po zarejestrowaniu się w aplikacji, wykonaj pierwszy depozyt (min. 50 ZŁ) i wpisz kod promocyjny VAVADA100 w odpowiedniej zakładce. Bonus zostanie przyznany automatycznie.

Czy mogę grać bez depozytu?

Vavada okresowo oferuje darmowe spiny za samą rejestrację, jednak główne bonusy wymagają wykonania depozytu. Warto śledzić aktualne promocje w aplikacji.

Dlaczego aplikacji nie ma w Google Play?

Ze względu na restrykcyjną politykę sklepu Google wobec aplikacji hazardowych. Pobieranie APK ze strony operatora jest w pełni bezpieczne i zapewnia dostęp do wszystkich funkcji.

Jak długo trwają wypłaty?

Czas realizacji wypłat zależy od metody: e-portfele (do 24h), karty bankowe (1-3 dni), kryptowaluty (do 1h). Wypłaty poniżej 2000 ZŁ nie wymagają weryfikacji.

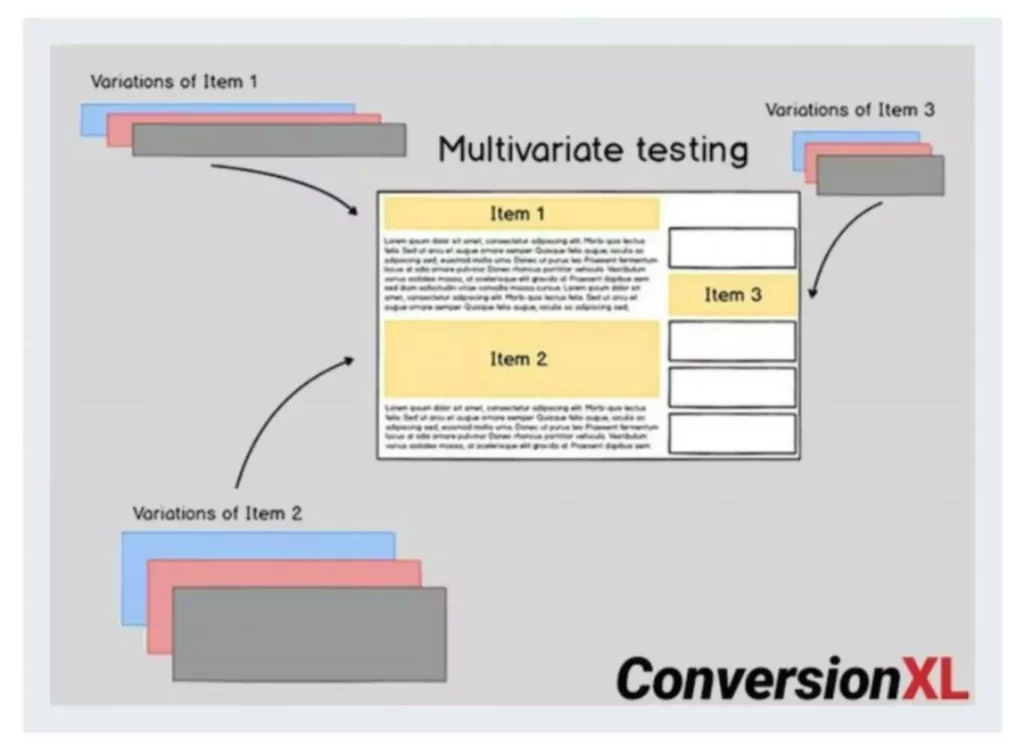

Programmers, analysts, operators, and users all play totally different roles within the various elements of testing, as shown in the figure under. Testing of hardware is usually provided as a service by distributors of apparatus, who will run their very own tests on tools when it is delivered onsite. Growth occurs in two-week sprints and we release functionality continuously, so the group gets quick feedback for its work.

Everybody concerned should as soon as once more agree on tips on how to decide whether or not the system is doing what it is alleged to do. This step will embody measures of error, timeliness, ease of use, proper ordering of transactions, acceptable down time, and understandable procedure manuals. When packages cross desk checking and checking with check information, they must go through hyperlink testing, which can be referred to as string testing. Hyperlink testing checks to see if packages that are interdependent really work collectively as deliberate. The idea of Desk Verify emerged in the early days of Computing, when engineers and programmers had restricted access to testing environments and real-world knowledge. To make sure the correctness of their designs, they relied on guide code evaluations and informal testing methods.

The left WHILE loop continues to dothisstuff, as long as count is lower than 10. The REPEAT loop stops repeating dothisstuff when the variable depend becomes larger than or equal to 10. By the way, do not be too concerned concerning the processing that dothisstuff really does.

Feedback!

All the system’s newly written or modified application programs—as well as new procedural manuals, new hardware, and all system interfaces—must be tested completely. Haphazard, trial-and-error testing will not suffice. Testing is completed throughout methods growth, not simply at the end.

Whether Or Not it’s to kickoff the story or for a dev-box, there will be instances when you want to meet. For example, if the feedback’s going forwards and backwards, it’s just too slow and impractical to be asynchronous. In such circumstances, set up a name and kind things out in real time.

Testing is achieved on subsystems or program modules as work progresses. Testing is completed on many alternative levels at varied intervals. Before the system is put into production, all applications have to be desk checked, checked with check knowledge, and checked to see if the modules work along with each other as deliberate. To scale back the necessity for conferences, your tales must have all the main points developers will need. This is the place the three amigos have to collaborate on writing person tales.

It is meant to show up heretofore unknown issues, to not show the perfection of applications, manuals, or tools. A good apply with desk-checks is to time-box them to 15 minutes in any other case they will end up being exploratory tests on the dev’s computer. Whereas lots of obvious defects show up in these dev-box exams, you’ll find a way to preempt them with a checklist. Groups can develop their very own checklist primarily based on the DoD that developers can then enrich with the acceptance standards for individual tales. Final, let’s talk about the 2 practices in question. The thought is to create suggestions loops within the dash.

The Testing Course Of – High Quality Assurance

Even skilled programmers make errors — a desk verify could assist catch and repair them earlier than a program goes by way of a proper run. The programmer who wrote the code typically checks it herself; if she identifies points, she shall be able to repair them on the spot before the project strikes onto the subsequent stage. If she doesn’t desk check and an error causes issues later down the road, it would delay a project. Errors may be harder to identify at a later stage. Methods testing consists of reaffirming the quality standards for system performance that had been arrange when the initial system specifications have been made.

A desk examine does not guarantee that a programmer will find mistakes. Programmers may miss things that must be fastened, simply because they wrote the code themselves and are too near it to be goal. Getting a unique programmer to desk examine could solve this concern. However, the individual working the examine additionally needs to understand the requirements behind the code earlier than JavaScript he can evaluate if it will work. Much of the duty for program testing resides with the unique author(s) of every program.

An algorithm is a set of instructions for solving an issue or undertaking a task. One widespread instance of an algorithm is a recipe, which consists of specific instructions for getting ready a dish or meal. Every computerized gadget uses algorithms to carry out its capabilities. A Desk Verify is a apply for use for verification when the pair of builders believe the development is complete. Peer review https://www.globalcloudteam.com/ will tends to extend the standard of the software production.

Even when working asynchronously, a lower overlap could cause an extended ready time and developers or testers would possibly end up blocking each other. It involves manually examining and verifying the correctness, logic, and completeness of a system or Course Of. In order to Enhance the efficiency of desk checking it’s important that this system evaluate the code against design specifications. That means we’re going to leap all the greatest way down to line eleven again. All of the processing exterior binary choice does not get done.

- Many groups also designate a lead developer, also recognized as a technical lead (TL).

- I’ve additionally seen a desk examine query record used to facilitate the assembly.

- They are specialists with real-world experience working in the tech trade and academia.

- Disclaimer out of the method in which, let’s discuss the ideas.

- Get Mark Richards’s Software Program Structure Patterns e book to higher perceive the way to design components—and how they should work together.

- In a pre-test loop, the processing condition whilst ever the situation is true.

In a structured walkthrough, for instance, the programmer is a half of a peer group that evaluations and analyzes the work prior to launch. The programmer sometimes gives the materials for evaluate to group members before the assembly. Throughout the meeting itself, she walks the group via desk check meaning the code. Ideally, the group will spot errors if they exist or make viable suggestions for improvement.

And the relational operator of equal to, to not equal to. You also need to reverse the logical condition that goes between those two from an OR to an AND. “Dev-done” record was usually referenced earlier than desk checks to assist prepare for it higher. I’ve additionally seen a desk examine question listing used to facilitate the meeting. Vipin Jain has 24 years of expertise within the IT business, during which he has acquired nice data of software projects, methodologies, and high quality. He has dedicated the last 18 years of his career to Software Program High Quality.

It includes reading by way of the capabilities inside the code and manually testing them, typically with a number of enter values. Developers might desk verify their code earlier than releasing a software program program to verify the algorithms are functioning effectively and accurately. Desk checking is a casual guide take a look at that programmers can use to verify coding and algorithm logic before a program launch. This permits them to identify errors which may forestall a program from working because it ought to. Trendy debugging instruments make desk checking much less important than it was up to now, but it could possibly nonetheless be a helpful means of recognizing logic errors. A desk examine is a review course of utilized in software program engineering to identify potential errors in code by manually analyzing it without working the program.

Line three signifies that we will begin that post-test loop. Line four says, that we’ll change the value of Z to what’s at present the value of Y. Line 5 tells us, we will enter a binary selection. So that binary selection, we need to verify if X is less than 7. This is where you must use your desk verify desk. So if it is a condition the place you are checking a worth, on this case, X is less than 7, we will return to the desk say, sure, X is less than 7, because it is equal to 1.

What is LLM & How to Build Your Own Large Language Models?

We clearly see that teams with more experience pre-processing and filtering data produce better LLMs. LLMs are very suggestible—if you give them bad data, you’ll get bad results. In our detailed analysis, we’ll pit custom large language models against general-purpose ones.

These four steps not only amplify the capabilities of LLMs but also facilitate more personalized, efficient, and adaptable AI-powered interactions. Ultimately, what works best for a given use case has to do with the nature of the business and the needs of the customer. As the number of use cases you support rises, the number of LLMs you’ll need to support those use cases will likely rise as well. There is no one-size-fits-all solution, so the more help you can give developers and engineers as they compare LLMs and deploy them, the easier it will be for them to produce accurate results quickly. Model drift—where an LLM becomes less accurate over time as concepts shift in the real world—will affect the accuracy of results.

Testing your model ensures its reliability and performance under various conditions before making it live. Subsequently, deploying your custom LLM into production environments demands careful planning and execution to guarantee a successful launch. Before deploying your custom LLM into production, thorough testing within LangChain is imperative to validate its performance and functionality. Create test scenarios (opens new window) that cover various use cases and edge conditions to assess how well your model responds in different situations. Evaluate key metrics such as accuracy, speed, and resource utilization to ensure that your custom LLM meets the desired standards. Now that you have laid the groundwork by setting up your environment and understanding the basics of LangChain, it’s time to delve into the exciting process of building your custom LLM model.

When designing your LangChain custom LLM, it is essential to start by outlining a clear structure for your model. Define the architecture, layers, and components that will make up your custom LLM. Consider factors such as input data requirements, processing steps, and output formats to ensure a well-defined model structure tailored to your specific needs.

Unlock the Power of Large Language Models: Dive Deeper Today!

This parameter essentially dictates how far back in the text the model gazes when formulating its responses (see excerpt of Wikipedia page about Shakespeare below for an example). While this hyperparameter cannot be directly adjusted by the user, the user can choose to employ models with larger/smaller context windows depending on the type of task at hand. While crucial, prompt engineering is not the only way in which we can intervene to tailor the model’s behavior to align with our specific objectives. Conversely, a poorly constructed prompt can be vague or ambiguous, making it challenging for the model to grasp the intended task.

How to use LLMs to create custom embedding models – TechTalks

How to use LLMs to create custom embedding models.

Posted: Mon, 08 Jan 2024 08:00:00 GMT [source]

An ROI analysis must be done before developing and maintaining bespoke LLMs software. For now, creating and maintaining custom LLMs is expensive and in millions. Most effective AI LLM GPUs are Chat PG made by Nvidia, each costing $30K or more. Once created, maintenance of LLMs requires monthly public cloud and generative AI software spending to handle user inquiries, which can be costly.

Factors like model size, training dataset volume, and target domain complexity fuel their resource hunger. General LLMs, however, are more frugal, leveraging pre-existing knowledge from large datasets for efficient fine-tuning. Designed to cater to specific industry or business needs, custom large language models receive training on a particular dataset relevant to the specific use case.

# Getting Familiar with LangChain Basics

While it’s not a perfect metric, it does indicate the overall increase in summarization effectiveness that we have accomplished by fine-tuning. Will be interesting to see how approaches change once cost models and data proliferation will change (former down, latter up). Per what salesforce data cloud is promoting, enterprises have their own data to leverage for their own private and secure models. Use cases are still being validated, but using open source doesn’t seem to be a real viable option yet for the bigger companies. Before designing and maintaining custom LLM software, undertake a ROI study. LLM upkeep involves monthly public cloud and generative AI software spending to handle user enquiries, which is expensive.

Pre-process the data to remove noise and ensure consistency before feeding it into the training pipeline. Utilize effective training techniques to fine-tune your model’s parameters and optimize its performance. The advantage of unified models is that you can deploy them to support multiple tools or use cases. But you have to be careful to ensure the training dataset accurately represents the diversity of each individual task the model will support. If one is underrepresented, then it might not perform as well as the others within that unified model. But with good representations of task diversity and/or clear divisions in the prompts that trigger them, a single model can easily do it all.

On the other hand, hyperparameters represent the external factors that influence the learning process and outcome. Exactly which parameters to customize, and the best way to customize them, varies between models. In general, however, parameter customization involves changing values in a configuration file — which means that actually applying the changes is not very difficult.

Good data creates good models

You can also combine custom LLMs with retrieval-augmented generation (RAG) to provide domain-aware GenAI that cites its sources. That way, the chances that you’re getting the wrong or outdated data in a response will be near zero. We use evaluation frameworks to guide decision-making on the size and scope of models.

- Working closely with customers and domain experts, understanding their problems and perspective, and building robust evaluations that correlate with actual KPIs helps everyone trust both the training data and the LLM.

- Planning your project meticulously from the outset will streamline the development process and ensure that your custom LLM aligns perfectly with your objectives.

- The NeMo method uses the PPO value network as a critic model to guide the LLMs away from generating harmful content.

The framework’s versatility extends to supporting various large language models (opens new window) in Python and JavaScript, making it a versatile option for a wide range of applications. When fine-tuning, doing it from scratch with a good pipeline is probably the best option to update proprietary or domain-specific LLMs. However, removing or updating existing LLMs is an active area of research, sometimes referred to as machine unlearning or concept erasure. If you have foundational LLMs trained on large amounts of raw internet data, some of the information in there is likely to have grown stale. From what we’ve seen, doing this right involves fine-tuning an LLM with a unique set of instructions. For example, one that changes based on the task or different properties of the data such as length, so that it adapts to the new data.

It might also be overly prescriptive, limiting the model’s capacity to generate diverse or imaginative responses. Without enough context, a prompt might lead to answers that are irrelevant or nonsense. The moment has arrived to launch your LangChain custom LLM into production. Execute a well-defined deployment plan (opens new window) that includes steps for monitoring performance post-launch. Monitor key indicators closely during the initial phase to detect any anomalies or performance deviations promptly. Celebrate this milestone as you introduce your custom LLM to users and witness its impact in action.

To set up your server to act as the LLM, you’ll need to create an endpoint that is compatible with the OpenAI Client. For best results, your endpoint should also support streaming completions. The key difference lies in their application – GPT excels in diverse content creation, while Falcon LLM aids in language acquisition. Research study at Stanford explores LLM’s capabilities in applying tax law. The findings indicate that LLMs, particularly when combined with prompting enhancements and the correct legal texts, can perform at high levels of accuracy.

Here, we need to convert the dialog-summary (prompt-response) pairs into explicit instructions for the LLM. It is essential to format the prompt in a way that the model can comprehend. Referring to the HuggingFace model documentation, it is evident that a prompt needs to be generated using dialogue and summary in the specified format below.

Below, this example uses both the system_prompt and query_wrapper_prompt, using specific prompts from the model card found here. If you are using other LLM classes from langchain, you may need to explicitly configure the context_window and num_output via the Settings since the information is not available by default. Available models include gpt-3.5-turbo, gpt-3.5-turbo-instruct, gpt-3.5-turbo-16k, gpt-4, gpt-4-32k, text-davinci-003, and text-davinci-002.

We’ll ensure that you have dedicated resources, from engineers to researches that can help you accomplish your goals. Our platform and expert AI development team will work with you side by side to help you build AI from the ground up and harness your proprietary data. To bring your concept to life, we’ll tune your LLM with your private data to create a custom LLM that will meet your needs. Build on top of any foundational model of your choosing, using your private data and our LLM development expertise.

Custom LLMs enable a business to generate and understand text more efficiently and accurately within a certain industry or organizational context. Fine-tuning a Large Language Model (LLM) involves a supervised learning process. In this method, a dataset comprising labeled examples is utilized to adjust the model’s weights, enhancing its proficiency in specific tasks. Now, let’s delve into some noteworthy techniques employed in the fine-tuning process. This means that a company interested in creating a custom customer service chatbot doesn’t necessarily have to recruit top-tier computer engineers to build a custom AI system from the ground up.

Fine-tuning Large Language Models (LLMs) has become essential for enterprises seeking to optimize their operational processes. While the initial training of LLMs imparts a broad language understanding, the fine-tuning process refines these models into specialized tools capable of handling specific topics and providing more accurate results. Tailoring LLMs for distinct tasks, industries, or datasets extends the capabilities of these models, ensuring their relevance and value in a dynamic digital landscape. Looking ahead, ongoing exploration and innovation in LLMs, coupled with refined fine-tuning methodologies, are poised to advance the development of smarter, more efficient, and contextually aware AI systems. It helps leverage the knowledge encoded in pre-trained models for more specialized and domain-specific tasks. Hello and welcome to the realm of specialized custom large language models (LLMs)!

Preparing your custom LLM for deployment involves finalizing configurations, optimizing resources, and ensuring compatibility with the target environment. Conduct thorough checks to address any potential issues or dependencies that may impact the deployment process. Proper preparation is key to a smooth transition from testing to live operation. Integrating your custom LLM model with LangChain involves implementing bespoke functions that enhance its functionality within the framework.

You’ve got the open-source large language models with lesser fees, and then the ritzy ones with heftier tags for commercial use. Fine-tuning custom LLMs is like a well-orchestrated dance, where the architecture and process effectiveness drive scalability. Optimized right, they can work across multiple GPUs or cloud clusters, handling heavyweight tasks with finesse. Adapter modules are usually initialized such that the initial output of the adapter is always zeros to prevent degradation of the original model’s performance due to the addition of such modules. The NeMo framework adapter implementation is based on Parameter-Efficient Transfer Learning for NLP.

Use Low-cost service using open source and free language models to reduce the cost. Hyperparameters are settings that determine how a machine-learning model learns from data during the training process. For LLAMA2, these hyperparameters play a crucial role in shaping how the base language model (e.g., GPT-3.5) adapts to your specific domain. Fine-tuning hyperparameters can significantly influence the model’s performance, convergence speed, and overall effectiveness. The basis of their training is specialized datasets and domain-specific content.

This helps attain strong performance on downstream tasks while reducing the number of trainable parameters by several orders of magnitude (closer to 10,000x fewer parameters) compared to fine-tuning. You can foun additiona information about ai customer service and artificial intelligence and NLP. Fine-tuning LLM involves the additional training of a pre-existing model, which has previously acquired patterns and features from an extensive dataset, using a smaller, domain-specific dataset. In the context of “LLM Fine-Tuning,” LLM denotes a “Large Language Model,” such as the GPT series by OpenAI. This approach holds significance as training a large language model from the ground up is highly resource-intensive in terms of both computational power and time. Utilizing the existing knowledge embedded in the pre-trained model allows for achieving high performance on specific tasks with substantially reduced data and computational requirements.

This fine-tuned adapter is then loaded into the pre-trained model and used for inference. Creating LLMs requires infrastructure/hardware supporting many GPUs (on-prem or Cloud), a big text corpus of at least 5000 GBs, language modeling algorithms, training on datasets, and deploying and managing the models. From machine learning to natural language processing, https://chat.openai.com/ our team is well versed in building custom AI solutions for every industry from the ground up. The process involves loading the data sources (be it images, text, audio, etc.) and using an embedder model, for example, OpenAI’s Ada-002 or Meta’s LLaMA to generate vector representations. Next, embedded data is loaded into a vector database, ready to be queried.

Good prompt engineering involves creating clear and onpoint instructions in a way that maximizes the likelihood of getting accurate, relevant, and coherent responses. A prompt is a concise input text that serves as a query or instruction to a language model to generate desired outputs. Put simply, it represents the most straightforward manner for human users to ask LLMs to solve a task. For those eager to delve deeper into the capabilities of LangChain and enhance their proficiency in creating custom LLM models, additional learning resources are available. Consider exploring advanced tutorials, case studies, and documentation to expand your knowledge base.

During the pre-training phase, LLMs are trained to forecast the next token in the text. Next comes the training of the model using the preprocessed data collected. Generative AI is a vast term; simply put, it’s an umbrella that refers to Artificial Intelligence models that have the potential to create content. Moreover, Generative AI can create code, text, images, videos, music, and more. These defined layers work in tandem to process the input text and create desirable content as output. Now, let’s perform inference using the same input but with the PEFT model, as we did previously in step 7 with the original model.

Enterprise LLMs can create business-specific material including marketing articles, social media postings, and YouTube videos. Also, Enterprise LLMs might design cutting-edge apps to obtain a competitive edge. Note that for a completely private experience, also setup a local embeddings model.

Whereas Large Language Models are a type of Generative AI that are trained on text and generate textual content. The Large Learning Models are trained to suggest the following sequence of words in the input text. The embedding layer takes the input, a sequence of words, and turns each word into a vector representation. This vector representation of the word captures the meaning of the word, along with its relationship with other words. Well, LLMs are incredibly useful for untold applications, and by building one from scratch, you understand the underlying ML techniques and can customize LLM to your specific needs. Now, we will use our model tokenizer to process these prompts into tokenized ones.

Plus, you might need to roll out the red carpet for domain specialists and machine learning engineers, inflating development costs even further. The total cost of adopting custom large language models versus general language models (General LLMs) depends on several variables. A dataset consisting of prompts with multiple responses ranked by humans is used to train the RM to predict human preference.

The choice of hyperparameters should be based on experimentation and domain knowledge. For instance, a larger and more complex dataset might benefit from a larger batch size and more training epochs, while a smaller dataset might require smaller values. The learning rate can also be fine-tuned to find the balance between convergence speed and stability. The specialization feature of custom large language models allows for precise, industry-specific conversations.

The integration of agents not only makes LLMs versatile but also enhances their capability to deliver tailored outputs specific to a given domain. This specialization ensures that the responses provided are not only accurate but also highly relevant to the user’s specific query. In the popular realm of conversational AI (e.g., chatbots), LLMs are typically configured to uphold coherent conversations by employing an extended context window. They also employ stop sequences to sieve out any offensive or inappropriate content, while setting the temperature lower to furnish precise and on-topic answers.

Based on the validation and test sets results, we may need to make further adjustments to the model’s architecture, hyperparameters, or training data to improve its performance. Microsoft recently open-sourced the Phi-2, a Small Language Model(SLM) with 2.7 billion parameters. This language model exhibits remarkable reasoning and language understanding capabilities, achieving state-of-the-art performance among base language models.

In training and inference, continuous token embeddings are inserted among discrete token embeddings according to a template provided in the model’s config. Prompt engineering involves customization at inference time with show-and-tell examples. An LLM is provided with example prompts and completions, detailed instructions that are prepended to a new prompt to generate the desired completion. Large language models (LLMs) are becoming an integral tool for businesses to improve their operations, customer interactions, and decision-making processes. However, off-the-shelf LLMs often fall short in meeting the specific needs of enterprises due to industry-specific terminology, domain expertise, or unique requirements. The lightning-fast spread of LLMs means that crafting effective prompts has become a crucial skill, as the instructions provided to the model can greatly impact the outcome of the system.

For accuracy, we use Language Model Evaluation Harness by EleutherAI, which basically quizzes the LLM on multiple-choice questions. The true measure of a custom LLM model’s effectiveness lies in its ability to transcend boundaries and excel across a spectrum of domains. The versatility and adaptability of such a model showcase its transformative potential in various contexts, reaffirming the value it brings to a wide range of applications. Custom LLMs, while resource-intensive during training, are leaner at inference, making them ideal for real-time applications on diverse hardware.

# Deploying Your Model

Design tests that cover a spectrum of inputs, edge cases, and real-world usage scenarios. By simulating different conditions, you can assess how well your model adapts and performs across various contexts. After meticulously crafting your LangChain custom LLM model, the next crucial steps involve thorough testing and seamless deployment.

This type of automation makes it possible to quickly fine-tune and evaluate a new model in a way that immediately gives a strong signal as to the quality of the data it contains. For instance, there are papers that show GPT-4 is as good as humans at annotating data, but we found that its accuracy dropped once we moved away from generic content and onto our specific use cases. By incorporating the feedback and criteria we received from the experts, we managed to fine-tune GPT-4 in a way that significantly increased its annotation quality for our purposes.

To begin, let’s open a new notebook, establish some headings, and then proceed to connect to the runtime. Vice President of Sales at Evolve Squads | I’m helping our customers find the best software engineers throughout Central/Eastern Europe & South America and India as well. For OpenAI, Cohere, AI21, you just need to set the max_tokens parameter

(or maxTokens for AI21).

This design enables ultra-fast querying, making it an excellent choice for AI-powered applications. The surge in popularity of these databases can be attributed to their ability of enhancing and fine-tuning LLMs’ capabilities with long-term memory and the possibility to store domain-specific knowledge bases. Before diving into building your custom LLM with LangChain, it’s crucial to set clear goals for your project. Are you aiming to improve language understanding in chatbots or enhance text generation capabilities? Planning your project meticulously from the outset will streamline the development process and ensure that your custom LLM aligns perfectly with your objectives. Obviously, you can’t evaluate everything manually if you want to operate at any kind of scale.

Key Features of custom large language models

All this corpus of data ensures the training data is as classified as possible, eventually portraying the improved general cross-domain knowledge for large-scale language models. Multilingual models are trained on diverse language datasets and can process and produce text in different languages. They are helpful for tasks like cross-lingual information retrieval, multilingual bots, or machine translation. All in all, transformer models played a significant role in natural language processing. As companies started leveraging this revolutionary technology and developing LLM models of their own, businesses and tech professionals alike must comprehend how this technology works. Especially crucial is understanding how these models handle natural language queries, enabling them to respond accurately to human questions and requests.

It excels in generating human-like text, understanding context, and producing diverse outputs. Say goodbye to misinterpretations, these models are your ticket to dynamic, precise communication. Moreover, we will carry out a comparative analysis between general-purpose LLMs and custom language models. NeMo provides an accelerated workflow for training with 3D parallelism techniques. It offers a choice of several customization techniques and is optimized for at-scale inference of large-scale models for language and image applications, with multi-GPU and multi-node configurations. Furthermore, to generate answers for a specific question, the LLMs are fine-tuned on a supervised dataset, including questions and answers.

ChatRTX is a demo app that lets you personalize a GPT large language model (LLM) connected to your own content—docs, notes, images, or other data. Leveraging retrieval-augmented generation (RAG), TensorRT-LLM, and RTX acceleration, you can query a custom chatbot to quickly get contextually relevant answers. And because it all runs locally on your Windows RTX PC or workstation, you’ll get fast and secure results. As shopping for designer brands versus thrift store finds, Custom LLMs’ licensing fees can vary.

At Signity, we’ve invested significantly in the infrastructure needed to train our own LLM from scratch. Our passion to dive deeper into the world of LLM makes us an epitome of innovation. Connect with our team of LLM development experts to craft the next breakthrough together. Moreover, it is equally important to note that no one-size-fits-all evaluation metric exists. Therefore, it is essential to use a variety of different evaluation methods to get a wholesome picture of the LLM’s performance. Considering the evaluation in scenarios of classification or regression challenges, comparing actual tables and predicted labels helps understand how well the model performs.

Because the original model parameters are frozen and never altered, prompt learning also avoids catastrophic forgetting issues often encountered when fine-tuning models. Catastrophic forgetting occurs when LLMs learn new behavior during the fine-tuning process at the cost of foundational knowledge gained during LLM pretraining. In a medical context, for example, the agent might help physicians treat patients best by leveraging tools for diagnosis, treatment recommendations, or symptom interpretation based on the user’s specific inquiry. The incorporation of vector stores on medical literature and instructions to behave as a helpful medical assistant empower the agent with domain specific information and a clear function. By “agents”, we mean a system where the sequence of steps or reasoning behavior is not hard-coded, fixed or known ahead of time, but is rather determined by a language model. Working closely with customers and domain experts, understanding their problems and perspective, and building robust evaluations that correlate with actual KPIs helps everyone trust both the training data and the LLM.

A higher rank will allow for more expressivity, but there is a compute tradeoff. Here, the model is prepared for QLoRA training using the `prepare_model_for_kbit_training()` function. This function initializes the model for QLoRA by setting up the necessary configurations. In this tutorial, we will be using HuggingFace libraries to download and train the model. If you’ve already signed up with HuggingFace, you can generate a new Access Token from the settings section or use any existing Access Token. Free Open-Source models include HuggingFace BLOOM, Meta LLaMA, and Google Flan-T5.

- Whether it’s enhancing scalability, accommodating more transactions, or focusing on security and interoperability, LangChain offers the tools needed to bring these ideas to life.

- It is an essential step in any machine learning project, as the quality of the dataset has a direct impact on the performance of the model.

- Well, LLMs are incredibly useful for untold applications, and by building one from scratch, you understand the underlying ML techniques and can customize LLM to your specific needs.

Recently, the rise of AI tools specifically designed to assist in the creation of optimal prompts promise to make human interactions with conversational AI systems even more effective. LLMs, or Large Language Models, represent an innovative approach to enhancing productivity. They have the ability to streamline custom llm model various tasks, significantly amplifying overall efficiency. Why might someone want to retrain or fine-tune an LLM instead of using a generic one that is readily available? The most common reason is that retrained or fine-tuned LLMs can outperform their more generic counterparts on business-specific use cases.

Bringing your own custom foundation model to watsonx.ai – IBM

Bringing your own custom foundation model to watsonx.ai.

Posted: Thu, 11 Apr 2024 07:00:00 GMT [source]

This section will guide you through designing your model and seamlessly integrating it with LangChain. After installing LangChain, it’s crucial to verify that everything is set up correctly (opens new window). Execute a test script or command to confirm that LangChain is functioning as expected.

Despite their power, LLMs may not always align with specific tasks or domains. To address use cases, we carefully evaluate the pain points where off-the-shelf models would perform well and where investing in a custom LLM might be a better option. When that is not the case and we need something more specific and accurate, we invest in training a custom model on knowledge related to Intuit’s domains of expertise in consumer and small business tax and accounting. The criteria for an LLM in production revolve around cost, speed, and accuracy. Response times decrease roughly in line with a model’s size (measured by number of parameters).

A custom LLM can generate product descriptions according to specific company language and style. A general-purpose LLM can handle a wide range of customer inquiries in a retail setting. Both general-purpose and custom LLMs employ machine learning to produce human-like text, powering applications from content creation to customer service. This comparative analysis offers a thorough investigation of the traits, uses, and consequences of these two categories of large language models to shed light on them.

Instead, they can seamlessly infuse the model with domain-specific text data, allowing it to specialize in aiding customers unique to that particular company. LangChain is an open-source orchestration framework designed to facilitate the seamless integration of large language models into software applications. It empowers developers by providing a high-level API (opens new window) that simplifies the process of chaining together multiple LLMs, data sources, and external services. This flexibility allows for the creation of complex applications that leverage the power of language models effectively. In the realm of advanced language processing, LangChain stands out as a powerful tool that has garnered significant attention. With over 7 million downloads per month (opens new window), it has become a go-to choice for developers looking to harness the potential of Large Language Models (LLMs) (opens new window).

ROUGE, or Recall-Oriented Understudy for Gisting Evaluation, is a set of metrics and a software package used for evaluating automatic summarization and machine translation software in natural language processing. The metrics compare an automatically produced summary or translation against a reference or a set of references (human-produced) summary or translation. Our aim here is to generate input sequences with consistent lengths, which is beneficial for fine-tuning the language model by optimizing efficiency and minimizing computational overhead. It is essential to ensure that these sequences do not surpass the model’s maximum token limit. We’ll create some helper functions to format our input dataset, ensuring its suitability for the fine-tuning process.

It lets you automate a simulated chatting experience with a user using another LLM as a judge. So you could use a larger, more expensive LLM to judge responses from a smaller one. We can use the results from these evaluations to prevent us from deploying a large model where we could have had perfectly good results with a much smaller, cheaper model. ChatRTX features an automatic speech recognition system that uses AI to process spoken language and provide text responses with support for multiple languages.

They are a set of configurable options determined by the user and can be tuned to guide, optimize, or shape model performance for a specific task. To embark on your journey of creating a LangChain custom LLM, the first step is to set up your environment correctly. This involves installing LangChain and its necessary dependencies, as well as familiarizing yourself with the basics of the framework. With all the prep work complete, it’s time to perform the model retraining. Whenever they are ready to update, they delete the old data and upload the new. Our pipeline picks that up, builds an updated version of the LLM, and gets it into production within a few hours without needing to involve a data scientist.

Сьогодні Інстаграм є однією з найпопулярніших соціальних мереж. Успіх у цій платформі залежить від кількості підписників і лайків, які ви… Samsung — один зі світових лідерів у виробництві смартфонів, відомий надійністю, технологічністю і продуманим дизайном.

Природно, що поки щодо перспектив Immediate Engineering не існує консенсусу у ком’юніті. У березні 2024 року IEEE Spectrum випустив статтю з гучним заголовком «ШІ Immediate Engineering помер». В матеріалі йдеться про те, що Intel Labs навчили велику мовну модель (LLM) створювати підказки для генерації зображень ефективніше за людей. Перші згадки про Prompt Engineer-ів як окрему професію з’явилися тільки рік тому. Програма Google Trends зафіксувала неабиякий бум запитів у квітні 2023.

Що може бути спільного у hip hop культури та організації заходів? Інженер-конструктор з виробів із металу та нержавійки – це престижна та високооплачувана професія, яка дозволяє реалізовувати унікальні проєкти. Наставництво ШІ-системи в ітеративному режимі – це ключ до успіху.

- Наставництво ШІ-системи в ітеративному режимі – це ключ до успіху.

- Можна багато говорити про безпеку криптовалютних гаманців, двофакторну автентифікацію, цифрову «гігієну» і надійність сучасних блокчейнів, таких як Bitcoin і Ethereum,…

- При повному або частковому відтворенні інформації посилання на poprofessii.in.ua обов’язкове (для інтернет-ресурсів – пряме гіперпосилання, відкрите для пошукових систем).

Сьогодні вже понад one hundred інтернет-магазинів в Україні… Усі промпт інженер іноді втомлюються від роботи, а в голові у нас час від часу можуть з’являтися думки про звільнення. Є бізнеси, дивлячись на які виникає відчуття, що вони взагалі не дбають про рекламу, маркетинг та залучення аудиторії.

Портал онлайн-курсів Udemy пропонує низку курсів з промт-інжинірингу генеративного ШІ, в тому числі з освоєння ChatGPT і використання Midjourney для створення зображень ШІ. Rakuten Viber, яким користуються 98% українців, ділиться статистикою про мобільні платформи, найпопулярніші бренди й моделі смартфонів, та як вони змінились… Креативна агенція MOKO Digital розробила серію анімаційних роликів про відповідальне батьківство та психічне здоровʼя чоловіків для проєкту «ТатоХаб», що реалізується… Малий та середній бізнес (МСБ) відіграє ключову роль в економіці України, складаючи 99% від загальної кількості підприємств, 51% ВВП і… У 2024 році 1,122 випускників онлайн-академії ІТ-професій Mate academy зробили перший крок у кар’єрі, почавши працювати на junior-позиціях. Мережа центрів підтримки підприємців Дія.Бізнес та мережа мультимаркетів «Аврора» оголосили про старт прийому заявок на освітньо-грантову програму «Траєкторія 2», щоб…

Однак головне – це практика і постійне самоосвіта, які роблять процес роботи зі штучним інтелектом більш інтуїтивним і результативним. Промпт-інженери – це фахівці, які розробляють і оптимізують запити чи інструкції для генеративних штучних інтелектів, таких як мовні моделі чи системи комп’ютерного зору. Ці спеціалісти відіграють ключову роль у тому, щоб зробити взаємодію з AI більш ефективною та результативною, а також покращити якість та релевантність генерованих даних. Компанії готові платити за інформацію аби зекономити час та заробляти більше.

Практикуйтеся давати чіткі інструкції, надавати конструктивний зворотній зв’язок і розбивати складні завдання на частини. Французская группа компаний электроники Thales — не на слуху у массового потребителя. Но с ее продукцией ежедневно сталкиваются миллионы людей… «Перелік професій, яким може знадобитися Prompt Engineering, неосяжний. З появою потужних інструментів на базі ШІ, таких як ChatGPT, Google Gemini, Claude AI і LLaMA, світ захопила нова хвиля…

Доступні садочки — це реалізація права на освіту для дітей та можливість повернутися на ринок праці для їхніх батьків. У каналі нового сервісу Viber Relationship українців запитали, що найбільше дратує їх на початку стосунків. Сьогодні у світі фінансів та інвестицій знання – це ключ до успіху. Зважаючи на стрімке зростання популярності криптовалют, підвищення криптограмотності стає… Наприкінці 2023 року стартувала Aware Consuming College — школа, яка допомагає людям вибудовувати здорові стосунки з їжею.

Электроконструкторы Как Альтернатива Гаджетам И Экранному Времени Для Детей (founderua)

Щоб закрити це повідомлення і підтвердити згоду на використання cookie на цьому сайті, натисніть кнопку “Ок”. Серед безлічі видів техніки американського бренду Apple найбільш відомим по праву вважається iPhone. З початку повномасштабного вторгнення 71% українців долучилися до волонтерської допомоги армії, внутрішньо переміщеним особам або постраждалим від війни.

Айтишники И Переводчики — Кто Остался За Бортом Рынка Труда Во Время Полномасштабной Войны

Інструменти генеративного штучного інтелекту – особливо ті, що здатні створювати текст, комп’ютерний код і графіку – зараз викликають великий ажіотаж (і неабияке занепокоєння). Однією з професій майбутнього називають посаду “prompt-інженер” або “інженер підказок” для ChatGPT, Midjourney, Secure Diffusion. Liga.Tech розповідає, що це за робота, яких знань вона вимагає та чи наймають таких працівників в Україні вже зараз. «Якщо більш глибоко зануритися у вакансії з припискою «AI», можна побачити, що вміння писати промпти зазначається як додатковий скіл або ж не єдиний серед списку. Промпти можуть написати будь-які розробники й інженери. Immediate Engineer – це інженер, який розробляє підказки для штучного інтелекту, щоб отримати найкращі результати від моделі GenAI.

Цей промпт чітко вказує на бажаний результат – отримання списку типових питань і прикладів відповідей, що робить його корисним для підготовки до співбесіди. Таке формулювання допомагає моделі зосередитися на точній задачі і надати найбільш релевантну інформацію, яка може допомогти користувачеві успішно пройти співбесіду. Створення запитів для ШІ здається нескладним, але майбутній скоуп завдань промпт-інженерів поки важко осягнути. Ми спитали експертів, чи вже потрібні промпт-інженери на ринку та хто може ними стати. Деякі організації, зокрема, Бостонська дитяча лікарня, наймали prompt-інженерів ще 2023 року. На біржі для фрілансерів Upwork є понад 60 пропозицій роботи, повʼязаної з immediate engineering.

Cloud computing has also turn into indispensable in business settings, from small startups to world enterprises, because it presents greater flexibility and scalability than conventional on-premises infrastructure. The finest cloud suppliers spend money on every layer of cloud safety across world information center areas as a part of their cloud’s total design and form a true partnership with you and your own technical workers. Such a multilayer strategy offers safety at the stage your business needs, serving to defend you and your clients while assembly regulatory and governance necessities. However, hyperscale cloud providers, that are scalable infrastructures which adapt in response to demand, may be expensive.

If functions can move via separate environments by way of connectivity or integration, the cloud surroundings can be thought of hybrid. Examples of a hybrid cloud system include one non-public cloud and one public cloud, two or more private clouds, or two or extra public clouds. It can even embrace digital environments which are linked to public or private clouds. Cloud computing depends heavily on virtualization and automation applied sciences. This simplifies the abstraction and provisioning of cloud resources into logical entities, letting customers easily request and use these assets. In less complicated phrases, the “cloud” doesn’t refer to something floating in the sky.

It Is flexible, scalable, and eliminates the necessity for physical storage units. After evaluating their use case, we recommended a hybrid cloud mannequin, to make sure even resource distribution and, due to this fact, value effectivity. Whereas this ensures better performance and security, it might possibly create real complications when migrating to a extra recent cloud-based setup. By utilizing a ready-made SaaS answer, you’ll find a way to validate your small business model, discover your product-market fit, and get readability on what you really need when it comes to infrastructure. It’s a secure, steady, and absolutely managed setting that frees you to focus on your product and prospects — not the plumbing behind it.

Cloud Computing Safety

The prices of cloud computing are sometimes billed on a pay-as-you-go foundation, meaning no capital outlay is required for hardware or infrastructure. Cloud providers enable anybody to entry the IT infrastructure wanted to build and keep digital systems, abstracting complex infrastructure so anybody can construct refined purposes quickly and scale globally. You can use cloud providers to add synthetic intelligence and machine learning (AI/ML), real-time knowledge analytics, and lots of other capabilities to your purposes. Salesforce Cloud makes a speciality of customer relationship administration (CRM) options, providing cloud-based software that helps businesses handle their sales, customer service, advertising, and extra.